在 AI 居品研发中,复杂奖励机制时时被视为普及模子性能的“灵丹仙丹”,但本色后果却时时事与愿违。本文通过饕餮蛇强化学习本质fss 露出,从查验弧线可视化的角度,深刻解析了复杂奖励机制失效的内在逻辑。

基于饕餮蛇强化学习的战术示寂分析与需求锚定

一、本质复盘:当奖励轨则复杂化时,模子究竟在“学”什么?在《强化学习RL-NPC复杂奖励机制的陷坑与需求简化战术》一文中,我揭示了复杂奖励机制导致模子性能退化的满足。

本文将从查验弧线可视化的视角,通晓这一满足背后的深层逻辑,并为AI居品司理提供可落地的需求惩处框架。

中枢问题:为什么看似合理的复杂轨则,反而让AI变得更“笨”?

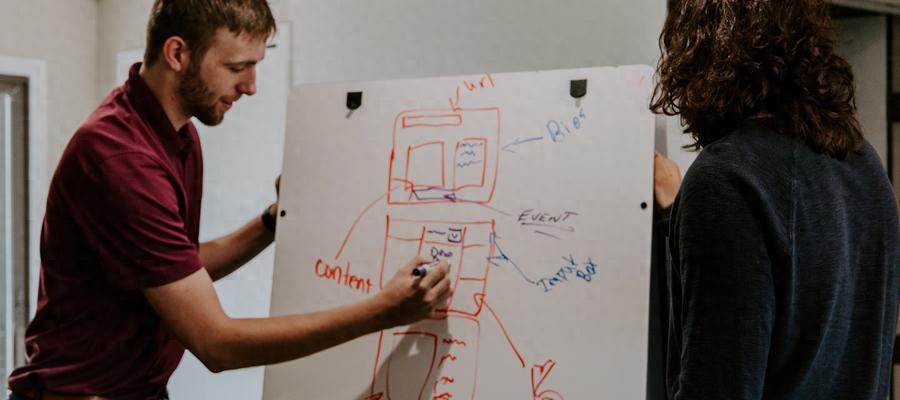

二、数据可视化:四张图看懂复杂轨则的“失效旅途”1、Environment/Cumulative Reward(积累奖励弧线)

对比分析:

苟简轨则(4条):奖励随查验步数稳步上涨,198万次后趋于雄厚(78.2分)

复杂轨则(8条):奖励初期少顷上涨后剧烈震憾,最闭幕竟然24.4分

居品启示:复杂轨则导致模子无法设置雄厚的奖励预期,需警惕需求膨大对本事决议的喧阗。

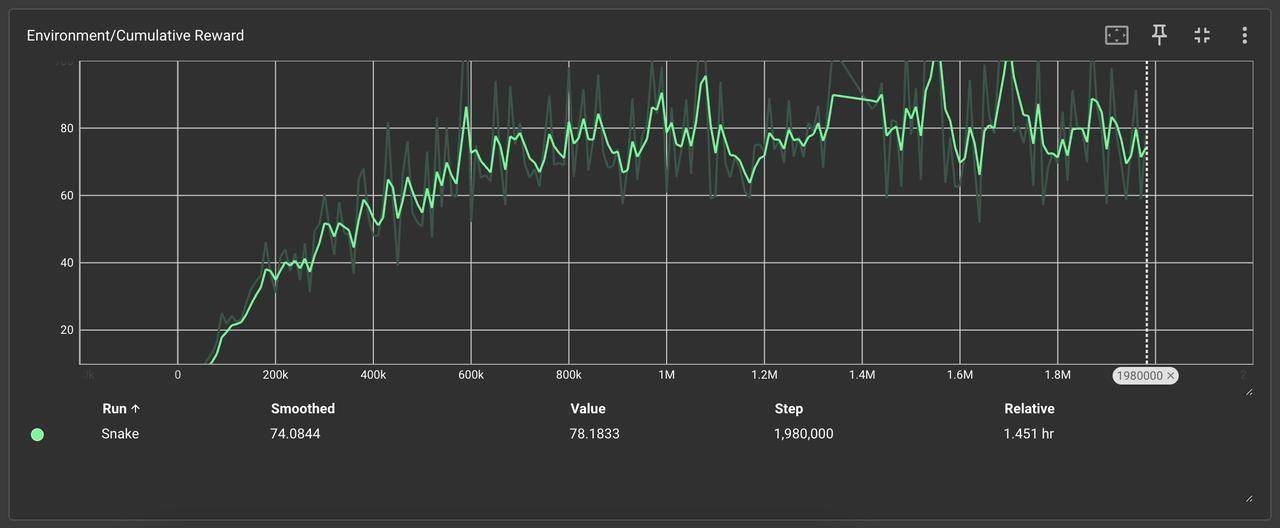

2、Environment/Cumulative Reward_hist(奖励散布直方图)

要津发现:

苟简轨则奖励靠拢在中高区间(40-80分)

复杂轨则奖励呈双峰散布(低分20-30分占比65%,偶发高分60+)

本事归因:复杂轨则下模子堕入局部最优,仅靠随即探索偶获高分,阐发轨则突破导致战术失焦。

3、Environment/Episode Length(单局步长弧线)

算作时势映射:

苟简轨则:步长随查验增多,AI主动探索环境(最长步数1200+)

复杂轨则:步长快速拘谨至300-500,AI收受保守绕圈战术

巨屌twitter决策逻辑:复杂轨则中的“生涯奖励”促使AI优先延迟存活时间,舍弃探索与觅食效力。

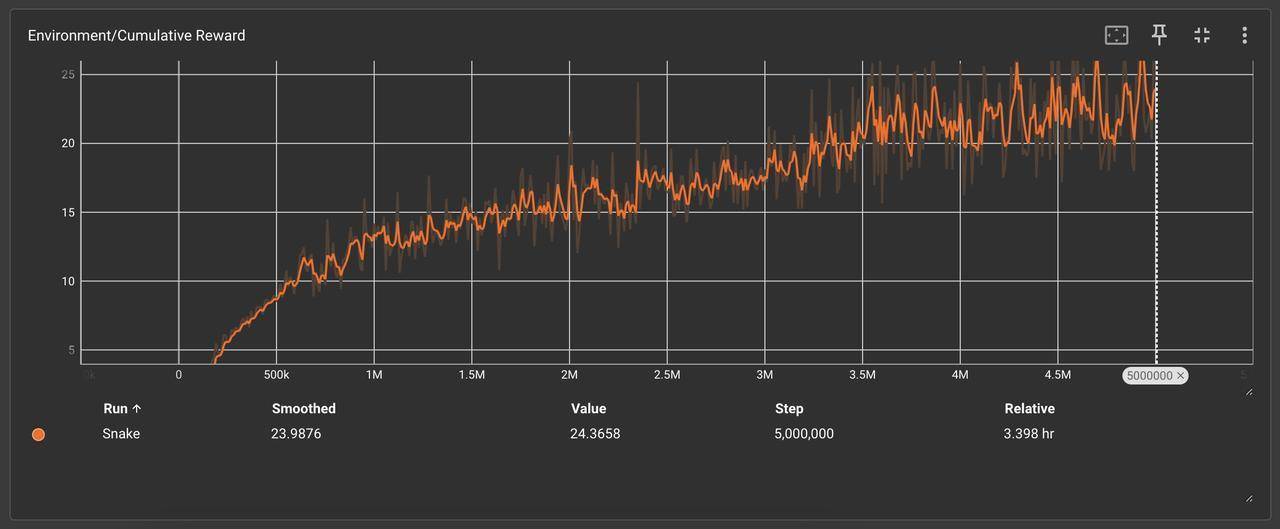

4、Losses/Policy Loss & Value Loss(战术示寂弧线和价值示寂)

拘谨效力对比:

苟简轨则:战术示寂雄厚下落,50万次后趋于玩忽

复杂轨则:示寂值剧烈波动,500万次仍未拘谨

居品化论断:复杂轨则显赫增多战术优化难度,征战周期可能超出合理阈值。

三、需求锚定:AI居品司理的“信号提纯”战术1、需求优先级量化模子代码仓库:

正在整理一经完成的两个 demo 的开动技俩文献,请敬请期待!

自查用具:

奖励轨则突破检测器(基于PyTorch梯度分析)战术雄厚性评估形貌盘(及时监控Loss弧线)五、操作实录:复杂轨则下的“调参倒霉”与破局演示“最危机的AI需求,时时披着‘良好化’的外套。”

作家:Mu先生Ai寰宇,公众号:Mu先生Ai寰宇

本文由 @Mu先生Ai寰宇 原创发布于东谈主东谈主皆是居品司理。未经作家许可,辞谢转载

题图来自Unsplash,基于CC0条约

该文不雅点仅代表作家本东谈主fss 露出,东谈主东谈主皆是居品司理平台仅提供信息存储空间行状